A Apple expande os recursos de acessibilidade, incluindo legendas ao vivo, lupa e reconhecimento de som

Apple na terça -feira compartilhou um punhado de Atualizações de acessibilidade Chegando à sua gama de produtos, projetados para ajudar com tudo, desde a leitura do texto até as legendas em tempo real até a redução da doença do movimento. O anúncio vem à frente de Dia global da conscientização sobre acessibilidade em 15 de maio, com os recursos previstos para lançamento ainda este ano.

A gigante da tecnologia está se preparando para sua conferência anual de desenvolvedores em todo o mundo em 9 de junho, durante a qual se espera compartilhar atualizações de software em suas plataformas, incluindo o que ele reservou para o iOS 19. Também é provável que compartilhe atualizações de inteligência da Apple, especialmente como outras empresas como a Samsung e o Google continuam a carregar seus telefones com recursos de AI. Muitos desses recursos movidos a IA também foram sobrecarregar os recursos de acessibilidade em dispositivos como o iPhone e o Pixel Phone.

“Na Apple, a acessibilidade faz parte do nosso DNA”, disse o CEO da Apple, Tim Cook, em comunicado. “Fazer tecnologia para todos é uma prioridade para todos nós, e estamos orgulhosos das inovações que estamos compartilhando este ano. Isso inclui ferramentas para ajudar as pessoas a acessar informações cruciais, explorar o mundo ao seu redor e fazer o que amam”.

As atualizações de acessibilidade da Apple chegarão no iPhone, iPad, Mac, Apple Watch e Apple Vision Pro. Aqui está o que em breve ficará disponível nesses dispositivos.

Etiquetas nutricionais de acessibilidade

Os rótulos nutricionais de acessibilidade mostrarão quais jogos e aplicativos da App Store têm os recursos suportados que você precisa.

Na App Store, uma nova seção nas páginas de produtos de aplicativos e jogos destacará os recursos de acessibilidade, para que você possa saber imediatamente se os recursos necessários estão incluídos antes do download. Esses recursos incluem narração, controle de voz, texto maior, contraste suficiente, movimento reduzido e legendas, bem como outras.

Os rótulos nutricionais de acessibilidade estarão disponíveis em todo o mundo na App Store. Os desenvolvedores terão acesso a orientações sobre quais critérios os aplicativos precisam atender antes de mostrar informações de acessibilidade em suas páginas de produtos.

Linente no Mac

O LoupiPer é uma ferramenta que permite que pessoas cegas ou de baixa visão sejam ampliadas, leiam o texto e detectem objetos ao seu redor no iPhone ou iPad. Agora, o recurso também está chegando ao Mac.

O Linente no Mac se conecta a uma câmera, como a do seu iPhone, para que você possa aumentar o zoom no que está ao seu redor, como uma tela ou quadro branco. Você pode usar a câmera de continuidade no iPhone para vincular -a ao seu Mac ou optar por uma conexão USB com uma câmera. O recurso suporta documentos de leitura com vista para a mesa. Você pode ajustar o que está na tela, incluindo brilho, contraste e filtros de cores, para facilitar a visualização de texto e imagens.

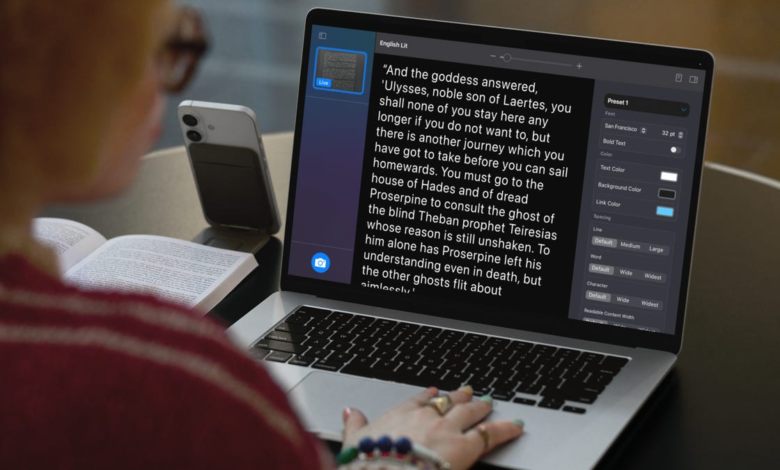

Leitor de acessibilidade

Este novo modo de leitura no iPhone, iPad, Mac e Vision Pro é voltado para facilitar a leitura do texto para pessoas com uma variedade de deficiências, incluindo aquelas com dislexia ou baixa visão. O leitor de acessibilidade permite personalizar o texto e aprimorar o que você está lendo adaptando fontes, cores e espaçamento. Também suporta Conteúdo faladopara que seu dispositivo possa ler em voz alta o que está na tela.

O leitor de acessibilidade pode ser usado em qualquer aplicativo e está incorporado a um Mensificador no iOS, iPados e macOS. Você pode iniciar o recurso para interagir com texto do mundo real, como nos menus e livros.

Acesso em Braille

O Braille Access permite que você transforme essencialmente o iPhone, iPad, Mac ou Vision Pro em um jogador de NOTE. Eles podem iniciar qualquer aplicativo digitando com a entrada da tela do Braille ou um dispositivo Braille vinculado, depois anote as notas no formato Braille e fazer cálculos usando Nemeth Braille.

Você também pode abrir os arquivos de formato Braille Ready no Braille Access, permitindo que eles acessem livros e arquivos criados em um dispositivo de tomada de nota em Braille. Uma integração de legendas ao vivo também permite transcrever conversas diretamente nas exibições do Braille.

Legendas ao vivo no Apple Watch

As legendas ao vivo e ao vivo mostrarão texto em tempo real no seu Apple Watch e permitirão que você controle remotamente uma sessão de audição ao vivo no seu iPhone.

A Live Listen é um recurso que leva o áudio capturado por um iPhone e o leva para seus AirPods, batidas ou aparelhos auditivos compatíveis, transformando essencialmente o telefone em um microfone remoto. Agora, esse recurso está chegando ao Apple Watch, junto com legendas ao vivo para exibir texto em tempo real do que está sendo ouvido por meio de um iPhone. Dessa forma, as pessoas podem ouvir o áudio enquanto veem essas legendas ao vivo no Apple Watch.

Você também pode usar seu Apple Watch como um controle remoto para iniciar ou terminar a escuta ao vivo, bem como para voltar, se você perdeu alguma coisa. Isso significa que você não terá que se levantar no meio da aula ou em uma reunião para pegar ou controlar seu iPhone – você pode fazer isso do outro lado da sala a partir do seu relógio. A Live Listen também pode ser usada com o recurso de aparelho auditivo no AirPods Pro 2.

Acessibilidade à visão no Apple Vision Pro

O Apple Vision Pro está adicionando um punhado de recursos para pessoas cegas ou com baixa visão. Uma atualização para o Zoom permitirá que você siga qualquer coisa em seu ambiente usando a câmera principal do Vision Pro. O reconhecimento ao vivo descreverá o que está ao seu redor, identificará objetos e lerá documentos usando o VoiceOver.

Uma nova API para desenvolvedores também permitirá que aplicativos aprovados acessem a câmera principal do fone de ouvido, para que você possa obter assistência ao vivo de interpretação visual em aplicativos como Be My Eyes.

Outras atualizações de acessibilidade

A Apple compartilhou um punhado de outras atualizações chegando aos seus recursos de acessibilidade, incluindo a adição de Dicas de movimento do veículoo que pode ajudar a reduzir a doença do movimento ao olhar para uma tela, para Mac. Você também pode personalizar os pontos animados que aparecem na tela no iPhone, iPad e Mac.

A voz pessoal permite que as pessoas que correm risco de perda de fala criem uma voz que soa como elas usando a IA e o aprendizado de máquina no dispositivo. Agora é mais rápido e mais fácil de usar. Em vez de ler 150 frases para configurar o recurso e esperar durante a noite para processar, a voz pessoal agora pode criar uma réplica de voz mais natural com apenas 10 frases gravadas em menos de um minuto. A Apple também está adicionando apoio ao espanhol no México.

O reconhecimento de nome o alertará se o seu nome estiver sendo chamado.

Semelhante ao rastreamento ocular, o que permite controlar seu iPhone e iPad usando apenas os olhos, o rastreamento da cabeça também permitirá que você navegue e controla seu dispositivo com os movimentos da cabeça.

Agora você pode personalizar os hápticos musicais no iPhone, que toca uma série de torneiras, texturas e vibrações ao longo do áudio na Apple Music. Você pode optar por experimentar esses hápticos por toda a música ou apenas para os vocais, e também pode ajustar a intensidade geral.

O reconhecimento de som, que alerta as pessoas surdas ou com dificuldades para ouvir como sirenes, campainhas ou buzinas, está adicionando reconhecimento de nomes para que eles também possam saber quando o nome está sendo chamado.

As legendas ao vivo também estão adicionando apoio a idiomas em mais partes do mundo, incluindo inglês (Índia, Austrália, Reino Unido, Cingapura), chinês mandarim (China continental), cantonês (China continental, Hong Kong), espanhol (América Latina, Espanha), francês (França, Canadá), japonês, alemão (alemão) e coreano.